自動並列化深層学習ミドルウェアRaNNC(ランク)をオープンソースで公開

〜超大規模ニューラルネットワークの学習が飛躍的に簡単に〜

2021年3月31日

国立研究開発法人情報通信研究機構

国立大学法人東京大学

ポイント

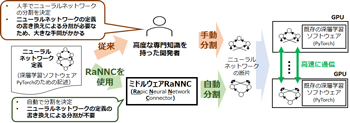

- 自動並列化深層学習ミドルウェアRaNNCを開発、オープンソースで公開開始

- 高度な知識と大きな作業コストを要する大規模ニューラルネットワークの学習が飛躍的に簡単に

- 深層学習の大規模化を容易にし、多様なAIシステムの更なる性能向上が期待される

背景

今回の成果

[画像クリックで拡大表示]

今後の展望

各機関の役割分担

- NICT: RaNNC全体の開発、動作検証、評価

- 東京大学: RaNNCの高速化

関連するプレスリリース

- 2021年3月31日 大規模Web情報分析システムWISDOM X「深層学習版」の試験公開を開始

補足資料

深層学習のためのニューラルネットワークの大規模化

大規模ニューラルネットワークの並列計算技術

参考文献

用語解説

本件に関する問合せ先

国立研究開発法人情報通信研究機構

ユニバーサルコミュニケーション研究所

データ駆動知能システム研究センター

田仲 正弘

E-mail:

広報(取材受付)

国立研究開発法人情報通信研究機構

広報部 報道室

Tel: 042-327-6923

E-mail:

国立大学法人東京大学

情報基盤センター 総務チーム

Tel: 03-5841-2710

E-mail: