プライバシー保護連合学習技術「DeepProtect」

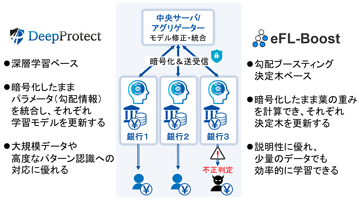

連合学習技術に暗号技術を融合することによって、NICTが独自に開発したプライバシー保護連合学習技術のこと。まず、各組織で持つデータを基に深層学習を行う際に、学習中のパラメータ(勾配情報)を暗号化して中央サーバに送り、中央サーバでは、暗号化したまま学習モデルのパラメータ(重み)の更新を行う。次に、更新されたこの学習モデルのパラメータを各組織においてダウンロードすることで、より精度の高い分析が可能になる。DeepProtectは、各組織から中央サーバにデータそのものを送ることなく、学習中のパラメータのみを暗号化して送信するが、このパラメータは、複数のデータを集計した統計情報とすることによって個人を識別できない状態にすることが可能であり、さらに、暗号化を施すため、データの外部への漏えいを防ぐことができる。

本技術により、パーソナルデータのような機密性の高いデータを外部に開示することなく、複数組織で連携して多くのデータを基にした深層学習が可能となる。eFL-Boostと比較して、大規模データや高度なパターン認識への対応に優れる。

本技術は、複数のジャーナルに採択・掲載されている[1,2]。また、動画による紹介を行っている[3]。

[1] L. T. Phong, Y. Aono, T. Hayashi, L. Wang, and S. Moriai, "Privacy-Preserving Deep Learning via Additively Homomorphic Encryption", IEEE Transactions on Information Forensics and Security, Vol.13, No.5, pp.1333-1345, 2018.

[2] L. T. Phong and T. T. Phuong, "Privacy-Preserving Deep Learning via Weight Transmission", IEEE Transactions on Information Forensics and Security, Vol.14, No.11, pp 3003-3015, 2019.

[3] 『NICTステーション 〜DeepProtect〜』

https://youtu.be/CpA9OD5vUIM

元の記事へ

決定木ベースのプライバシー保護連合学習「eFL-Boost」

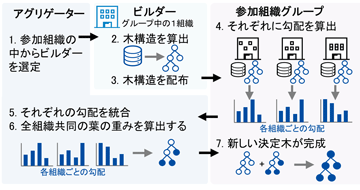

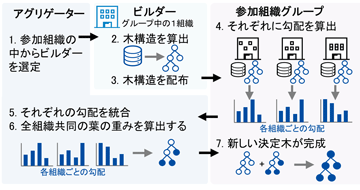

図3. 勾配ブースティング決定木に基づく連合学習

[画像クリックで拡大表示]

神戸大学とNICTはプライバシー保護に配慮した勾配ブースティング決定木の連合学習方式である eFL-Boost(Efficient Federated Learning for Gradient Boosting Decision Trees)を開発した[1]。eFL-Boostは、異なる組織が互いにデータを開示することなく、一つの勾配ブースティング決定木モデルを組織間で協調して学習する組織間連合学習スキームである。学習過程では、木構造の決定を特定の組織がローカルで行い、葉の重みを全組織で連携して計算することで、自組織のデータで学習した決定木構造を他組織に明かさないでプライバシー保護を実現しつつ、実用的な組織間通信量で高速かつ高精度と評価されるXGBoostと同等の性能を達成することに成功した。組織間で共有されるのは、プライバシーリスクの低い統計情報のみであり、準同型暗号で暗号化したまま、葉の重みを計算できる[2]。eFL-Boostは、深層学習と比較して各特徴量の解析結果への寄与率を出力できるため説明性に優れ、少量のデータでも効率的に学習できる手法であり、非数値データを取り扱う必要性のあるケースなど、DeepProtectとうまく使い分けていくことが望まれる。

なお、本成果については国際特許出願(PCT)を行い、日本国内への移行手続きおよび米国への移行出願も完了している[3,4]。

[1] F. Yamamoto, S. Ozawa, L. Wang, “eFL-Boost: Efficient Federated Learning for Gradient Boosting Decision Trees,” IEEE Access, vol.10, pp.43954-43963, 2022. https://ieeexplore.ieee.org/document/9761890

[2] Le Trieu PHONG, Tran Thi PHUONG, Lihua WANG, Seiichi OZAWA, Privacy-Preserving Federated Learning with Neural-Network-Based and Decision-Tree-Based Approaches, IEICE TRANS. INF. & SYST., VOL.E107-D, NO.1 JANUARY 2024.【Invited Paper】

[3] 国際出願PCT/JP2021/48383 「協調学習システム及び協調学習方法」 (国内移行出願2023年5月12日完了)、発明者:王立華、山本楓己、小澤誠一

[4] 出願番号:18/269747「Federated Learning System and Federated Learning Method”」(2023年6月26日出願)、発明者:Lihua Wang, Fuki Yamamoto, Seiichi Ozawa,

継続学習

継続学習(Continual Learning) とは、機械学習モデルが新たなデータやタスクを継続的に学習しながら、既存のデータやタスクから得た情報・知識を保持したモデルを生成することを目的とした手法である。従来の機械学習では、全てのデータを一括して学習する「一括学習(batch learning)」が一般的であったが、実世界の多くの応用では、データが逐次的に到着するため、モデルが新規のデータの到着に順応し続けることが求められる。例えば、金融取引情報のように時系列で更新されるデータや、ユーザーの行動履歴が常に変化する状況においては、モデルが変化に即応して学習内容を更新する必要がある。継続学習は、こうした状況において忘却(catastrophic forgetting)を抑制しつつ、過去の知識を活かしながら新たな知識を蓄積することを可能にし、長期的な適応力を持つモデルの構築を支援する。

元の記事へ

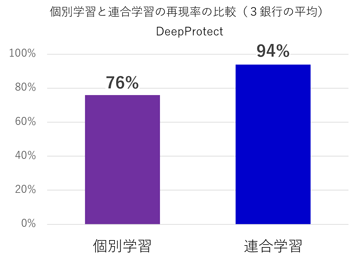

再現率

実際に「不正」なデータの中で、モデルが「不正」と正しく予想できた割合を示す指標。再現率が高いほど、取りこぼしなく正しく検知できていることを意味する。再現率は、不正検出など「取りこぼしを減らすことが重要なケース」で重視される。

元の記事へ

適合率

モデルが「不正」と予測したデータの中で、実際に「不正」なデータである割合を示す指標。適合率が高いほど、誤検出が少なく、正確に予想できていることを意味する。適合率は、スパムメールの検出など「誤検出を減らすことが重要なケース」で重視される。

元の記事へ

勾配ブースティング決定木

勾配ブースティング決定木(Gradient Boosting Decision Trees, GBDT)は、複数の決定木モデルを逐次的に構築・統合することで、高精度な予測を実現する機械学習手法である。単一の決定木では予測精度に限界があるが、GBDTでは各決定木が直前のモデルで生じた誤差を補うように設計されており、これを繰り返すことで予測誤差を徐々に修正し、モデル全体の性能を高めていく。GBDTは決定木を基盤としており、各木の貢献度や特徴量の重要度が明示的に計算できるという特徴がある。これは深層学習にはない特徴であり、深層学習と比較して出力結果の解釈がしやすいという利点を持つ。決定木は、「どの特徴量がどのような条件で予測に影響したのか」を分岐のルールとして明示的に示すため、人間にも直感的に理解しやすい構造になっている。また、GBDTは浅い決定木を繰り返し組み合わせて誤差を修正しながら学習を進める手法であるため、外れ値に対し頑強であり、大量のデータがなくても過学習を抑えつつ効率的に高い予測性能を発揮することができる。さらに、数値データに限らず、「はい/いいえ」やカテゴリ名といった非数値データを直接扱える実装が多く、実用性に優れた汎用的なアルゴリズムとして広く活用されている。

元の記事へ

ml.nict.go.jp

ml.nict.go.jp