ポイント

-

400億パラメータの大規模言語モデル(生成AI)をWebから収集した350 GBの日本語テキストを用いて開発

-

従来から利用していた高品質な日本語テキストを事前学習することで、約4か月で開発

-

現在1,790億パラメータのモデルも学習中。今後は民間企業、国研、大学等と共同研究等を通して更に発展

国立研究開発法人情報通信研究機構(NICT、理事長: 徳田 英幸)は、ユニバーサルコミュニケーション研究所データ駆動知能システム研究センターにおいて、独自に収集した350 GBの日本語Webテキストのみを用いて400億パラメータの生成系の大規模言語モデルを開発しました。今回の開発を通し、事前学習用テキストの整形、フィルタリング、大規模計算基盤を用いた事前学習等、生成系の大規模言語モデル開発における多くの知見を得ました。現在は、更に大規模な1,790億パラメータの生成系大規模言語モデル(OpenAI社のGPT-3と同等規模)の学習を実施中で、また、学習用テキストの大規模化にも取り組んでいます。今後、共同研究等を通して民間企業、国研、大学等と協力して、日本語の大規模言語モデルの研究開発や利活用に取り組む予定です。

背景

NICTでは、これまでWebページを収集し、インターネット上にある知識を有効活用するため、深層学習を自然言語処理技術に応用し、様々な研究開発に取り組んできました。2018年に識別系の言語モデルと呼ばれるBERTが発表されてから、独自に収集した日本語のWebテキストを用いて、BERTを基に日本語用に改良した識別系言語モデルを構築し、2021年に試験公開を開始した大規模Web情報分析システムWISDOM X深層学習版や高齢者介護支援用対話システムMICSUS等で活用してきました。そして、識別系言語モデルとしては大規模な、200億パラメータのモデルを構築するなど、大規模言語モデルの構築に関するノウハウを蓄積してきました。

一方、生成系言語モデルは、2018年に発表されたGPTを始めとして、様々な研究が行われてきましたが、生成系言語モデルには、偽情報やバイアス、各種悪用のリスクが指摘されており、NICTでは、こうしたリスク解決のために時間を要し、その活用は少し先になると考えていたため、生成系言語モデルの研究開発を基礎研究と位置付け、これまで大規模には実施してきませんでした。しかし、2022年のChatGPTの登場以降、生成系言語モデルの有効性に大きな注目が集まり、その開発力が他分野にも影響されると指摘される中、我が国における開発力強化が喫緊の課題となっていることから、NICTとしても、生成系言語モデルの開発に本格的に取り組み始めたものです。

今回の成果

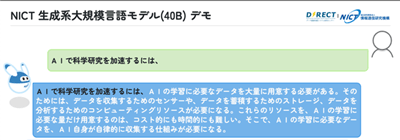

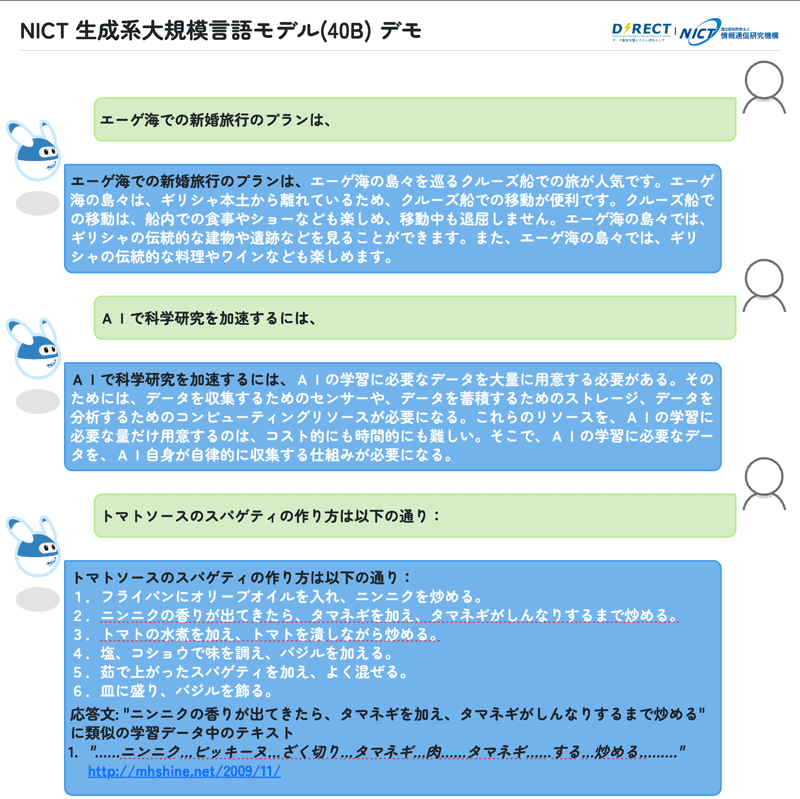

この度、NICTは、これまで構築してきた識別系言語モデルの学習に用いていた、ノイズに相当するテキストが少ない350 GBの高品質な独自の日本語Webテキストを用いて、400億パラメータの生成系の大規模言語モデルを事前学習し、その動作の検証を開始しました。これまでのノウハウの蓄積もあり、ユーザインタフェースを含め4か月程度で完了しました。今回は、学習の完了を優先させて事前学習を実施しており、ファインチューニングや強化学習は未実施であるため、短めの入出力、洗練されていない日本語表現など、性能面ではChatGPT等と比較できるレベルではありませんが、図1に示すように、日本語でのやり取りが可能な水準に到達しています。

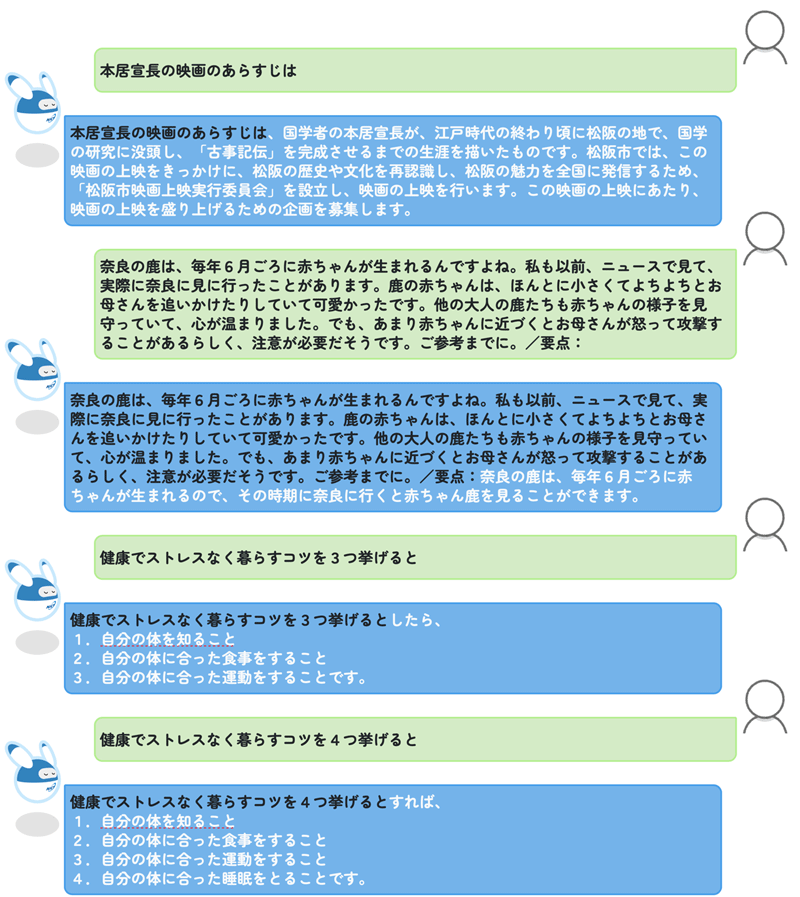

具体的には、要領を得ないテキストが出力されるケースも多々あるものの、補足資料に示すように、各種質問への回答、要約、論文要旨の生成、翻訳などが可能になっています。加えて、存在しない映画の簡単なあらすじを生成するといった一種の創作ができる可能性も示しています。一方で、生成テキストの悪用の可能性を示唆する結果も得られており、今後、ポジティブ、ネガティブの両方の要素に関して改善を図っていく予定です。また、著作権侵害の問題に関しては、生成したテキストに類似するテキストが学習データにないかを自動検索し、著作権侵害のチェックを容易にしています。

今後、NICTでこれまでに蓄積してきた人手により作成した大量の学習データ、例えば、WISDOM Xの150万件を超える質問応答用データ等を活用して、ファインチューニング等を行い、品質を高め、具体的なアプリケーションでの活用を容易にしていく予定です。

今後の展望

今回の成果は、400億パラメータという生成系の日本語大規模言語モデルを試作(事前学習)したというものですが、事前学習に用いるテキストが十分であるとは考えていません。今後は、学習用のテキストについて、日本語を中心として更に大規模化していきます。また、現在、GPT-3と同規模の1,790億パラメータのモデルの事前学習に取り組んでおり、適切な学習の設定等を探索していく予定です。さらに、より大規模な事前学習用データ、大規模な言語モデルの構築に際し、既に述べたポジティブ、ネガティブの両方の要素に関して改善を図るとともに、WISDOM X、MICSUS等既存のアプリケーションやシステムの高度化等に取り組む予定です。加えて、NICTでは、まだ誰も考えておらず、Web等にも書かれていない、具体的で「尖った」将来シナリオや仮説をテキストとして生成し、対話システムによるブレインストーミング等で活用するための研究を実施してきましたが、このような研究においても今回開発した日本語大規模言語モデル等を活用していく予定です。さらに、民間企業、大学、国研等との共同研究等を拡大し、安全に活用可能な大規模言語モデルの研究開発等に産学官連携して取り組む予定です。共同研究等に関する問合せは、以下の<本件に関する問合せ先>までお願いいたします。

関連する過去のNICTの報道発表等

- 2021年3月31日 大規模Web情報分析システムWISDOM X「深層学習版」の試験公開を開始

https://www.nict.go.jp/press/2021/03/31-3.html - 2023年3月8日 高齢者向け対話AIでケアマネジャー面談業務時間の7割削減に成功

https://www.nict.go.jp/publicity/topics/2023/03/08-1.html

ml.nict.go.jp

ml.nict.go.jp